DeepMind找到了破解深度学习黑匣子的方法

此前,我们已经对“黑匣子”问题有了初步探讨,发现许多科学家都在努力弄清楚其中的“奥秘”。因为对神经网络深层功能的理解,不仅有助于我们了解其决策机制,同时我们构建更为强大的人工智能系统也至关重要。

而最近,DeepMind的研究人员在一篇论文中,也解释了他们如何通过逐一删除单个神经元的方式去理解和判断神经网络的性能。他们认为,理解神经科学与深度学习神经网络之间关联性的重要方法之一,正是调查个体神经元的作用,特别是那些易于解释的神经元。

研究人员开发了专门的图像分类模型,然后逐一删除其中几个神经元,从而测量每个删除对模型结果的影响。

据DeepMind称,他们的发现产生了两个结果:

虽然以往的众多研究都集中于理解易于解释的单个神经元(例如'猫神经元',或者深层网络内隐藏层中的神经元等等只会对猫的图像产生反应的单元),但结果显示,它们在重要性上并不比综合且难以解释的神经元更高;

能够对从未见过的图像进行正确分类的神经网络,在神经元缺失适应性方面要比只能够对已经见过的图像进行分类的网络强。有点拗口,我们换句话来说,也就是适应度更高的网络比单纯依靠记忆起效的网络更能摆脱对单一神经元的依赖。

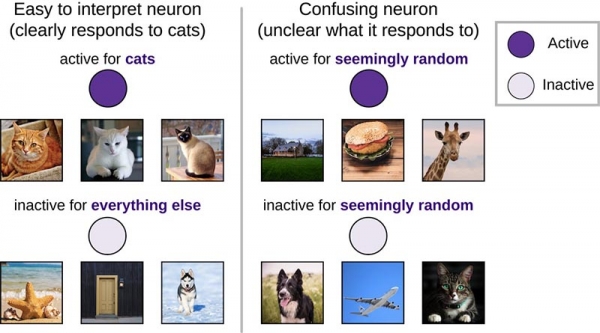

"选择性"神经元可能较易解释,但其重要性尚不明确

研究人员广泛分析了只能对单一输入图像类别作出响应,且易于解释的神经元(即“选择性”神经元)。他们发现,在深度学习当中,此类神经元包括了"猫神经元"、情绪神经元以及概括神经元; 而在神经科学领域,此类神经元则包括Jennifer Aniston神经元等。然而,这些仅占少数比例的高选择性神经元在重要性上到底与其它低选择性、更令人费解且难以解释的神经元有何区别,目前还不得而知。

DeepMind找到了破解深度学习黑匣子的方法

▲具有清晰响应模式的神经元(例如对猫的图像活跃,但对其它图像皆不敏感的神经元)比综合性的神经元(即能够对各类随机图像集发生反应的神经元)更易于解释

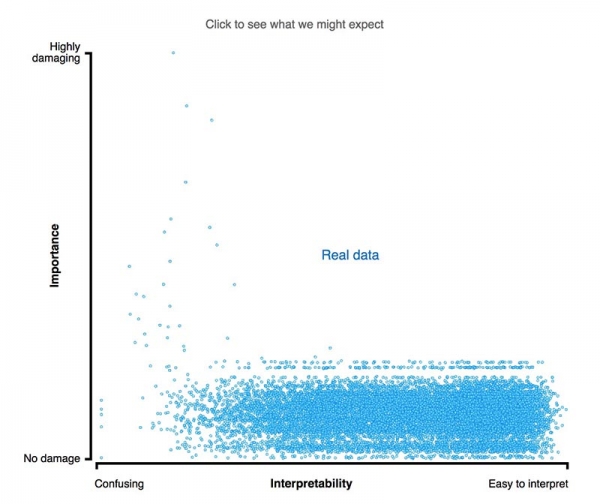

而为了评估神经元的重要性,研究人员在测试当中移除了部分神经元,从而观察网络的分类任务处理效能所发生的变化。如果其中某个神经元非常重要,那么将其移除就会产生极大的破坏性,并显著降低网络效能。相反,如果移除的神经元并不太重要,那么就不会造成什么影响。

DeepMind找到了破解深度学习黑匣子的方法

▲神经元缺失对简单神经网络所造成影响的概念示意图。较深的神经元往往更为活跃。尝试点击隐藏层神经元并将其移除,观察输出神经元的活动所发生的改变。需要注意的是,移除一个或两个神经元对输出结果的影响很小,而移除大部分神经元则会产生显著的影响,并且其中一部分神经元确实比其它神经元更为重要!

令人惊讶的是,研究人员发现选择性与重要性之间几乎没有关系。换句话说,"猫神经元"并不比综合性的神经元更为重要。这一发现与最近在神经科学方面的研究进展相互印证,目前科学家们已经证明那些作用不明的神经元实际上能够提供丰富的信息。这意味着我们必须迈过易解释神经元这道难关,才有可能真正搞清楚深层神经网络的运作机制。

DeepMind找到了破解深度学习黑匣子的方法

▲虽然"猫神经元"可能更易于解释,但其重要性并不比综合性且不具备明确偏好的神经元更高。可以点击图中标记,看看重要性与解释性之间到底存在着怎样复杂的关系

因此,研究人员的结论是,尽管可解释神经元在直觉上更易于理解(比如"它喜欢狗"),但其重要性并不一定会比缺少明显偏好的综合性神经元更高。

推广能力更强的网络也具有更大的弹性

我们所构建的智能系统,只有被推广到更多场景应用中,才被称为真正具备"智能"。举例来说,如果一套图像分类网络只能对以前见过的特定小狗图片进行分类,却无法对新的小狗图像完成识别,就可以说是不具备智能。Google Brain、伯克利以及DeepMind最近在ICLR 2017上获得最佳论文奖项的合作论文就提到,深层网络能够简单记住其训练当中所见到的每一幅图像,这代表着其学习方式与人类仍然存在巨大差异。

然而,目前我们往往很难判断一套神经网络是否已经学会了足以推广到新场景应用的能力。为此,通过逐渐移除越来越大的神经元组,研究人员发现相对于简单记忆以往在训练期间见到过的网络,适应性更强的网络对神经元缺失拥有更好的弹性表现。换句话说,适应性较强的网络更难被破坏(当然,如果神经元移除至一定程度,其仍然会遭到破坏)。

DeepMind找到了破解深度学习黑匣子的方法

▲随着越来越多的神经元被移除,具有广泛适应性的网络在效能下降速度方面远低于记忆性网络

通过这种网络稳健性衡量方式,科学家将能够评估是否能够通过为一套网络提供不符合要求的记忆而对其进行"欺骗"。此外,了解网络在记忆过程当中的变化也将有助于我们构建新的网络,从而保证更少地依赖记忆、更多地建立概括能力。

总而言之,这些发现确实能够被用于理解神经网络的力量。通过这些方法,我们发现高选择性神经元在重要性上并不强于非选择性神经元,而适应性更高的网络对单一神经元的依赖性也要低于单纯记忆型网络。这些结果意味着,单一神经元的重要性并不像人们想象中的那么高。

TOP

- 娱乐淘金/

- 行业/

- 政策/

- APP

热门话题

-

网红产品“遛娃神器”被曝存隐患 网购平台仍在售

央视《每周质量报告》曝光被称为“遛娃神器”的儿童轻便童车,抽...

互联网技术

-

事关生死:在医院ICU病房里人工智能可以做什么?

在医院的重症监控病房(简称ICU)当中,病情严重的患者需要全天连...

电商

最新科技

-

很远的地方:清晰视界保卫战

文质彬彬的书生,气质非凡的才女,在从前人们的印象里无一不带着...

资讯视频

- 财经 京东吞下1号店 刘强东打的什么算盘?今天凌晨,国内电商企业京东商城和沃尔玛宣布达成一系列深度战略合作。通过整合双方在电商和零售领域的巨大...

- 习近平视察“互联网之光”博览会国家主席习近平16日在浙江省乌镇视察“互联网之光”博览会。习近平强调,互联网给人们的生产生活带来巨大变...

- 他花了百万美元,买下色情网站,为了造飞碟!“飞碟音响”的想法,来自于Allen(张海星)和好朋友Steven(朱田俊)一次在港式茶餐厅的闲聊。他们看见一...

- 京东618用30架无人机表演高科技飞行秀近日,为迎接京东618全民购物的狂欢节,京东数码携手亿航无人机在北京上演了一场与众不同的无人机编队表演,...

- 华为荣耀8曝光 小米自行车发布华为荣耀8曝光 小米自行车发布 富士康收购夏普 魅族又要办演唱会